3.テレビ会議の草創期【デジタル編】

「テレビ会議入門編2」第3回目は、「テレビ会議の草創期【デジタル編】」です。前回は、アナログ時代のテレビ会議についてご説明いただきました。今回は1980年代後半以降のデジタル時代についてお伺いします。

1984年頃から時代はアナログからデジタルへと変化し、それはテレビ会議でも同様だったわけですね。

アナログからデジタルに変化した大きなエポックとして挙げられるのは、1988年4月からNTTがISDNの商用サービス「INSネット64」を開始した ことですね。ISDNというのは端末、つまりユーザーのところまでデジタル化できるわけです。それまでと大きく違う点はそこですね。

ビットレートは64kbpsなので十分とはいえませんが、一方で圧縮符号化の技術も進展し、研究や開発、標準化が行われて、1990年には私も携わったH.261ができました。

そのような技術とタイアップして、現実的にISDNでテレビ会議を展開できるようになったのが、1990年頃でしょうか。

遅延があるにもかかわらず、なぜアナログよりもデジタルがいいと言われるのでしょうか。

デジタルの大きな利点は4つです。

1つめは伝送面、2つ目は信号処理と端末のコスト面、3つ目は安定性、最後は運用の容易さ・自由度の高さです。

まずは伝送についてお話しします。

アナログ伝送というのは、距離が伸びれば伸びるほど加算的にいろんな雑音が増えていきます。それに対してデジタルは「0」と「1」しか送りません。たとえ 「0」が「0.2」になってもかまわないし、「0.3」や「0.4」になってもいいんです。いくら雑音などの妨害がある形で送ったとしても、「0」は 「0」、「1」は「1」として回復できる程度であれば、完璧に元に戻るということです。

デジタルでも中継器自体は必要ですが、雑音やひずみが累積しません。どんなにたくさん中継して長距離になっても雑音は増えません。「累積しない」というのがキーワードです。

これが伝送面での利点ですね。

次に2つ目の信号処理について。

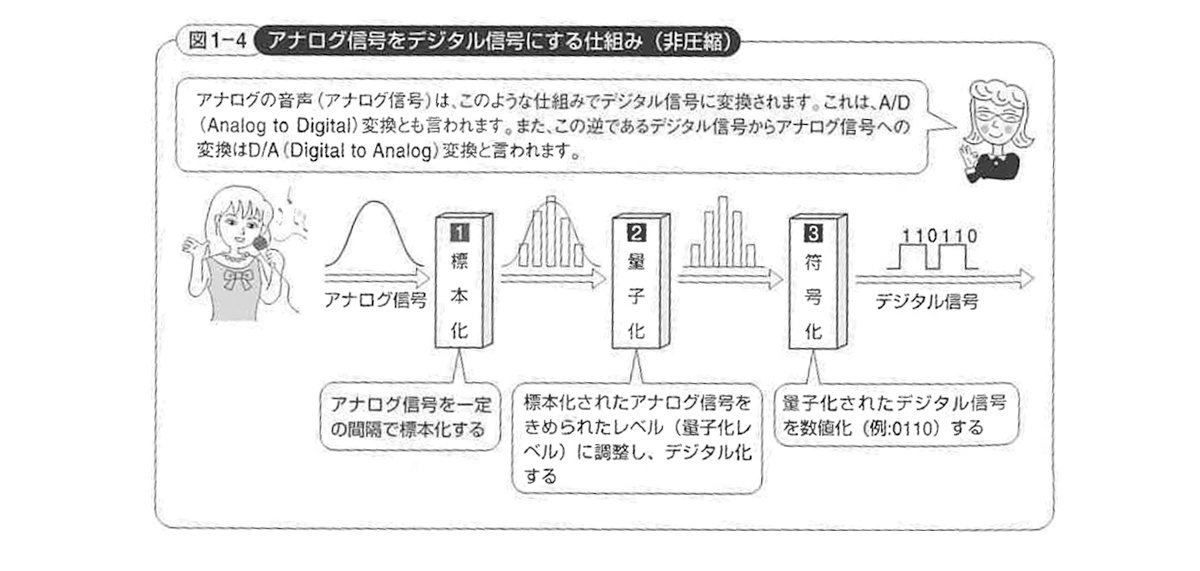

ここにある映像があったとします。それを単にデジタル化しただけでは、伝送するのに広い帯域幅が必要だという点ではアナログと変わりません。それをさらに圧縮することで、実用的な帯域幅で伝送できるようになります。

たとえばテレビ会議では1/20程度に圧縮されます。40Mbpsの情報を1/20に圧縮すれば2Mbpsですね。1/20ないし1/30に圧縮して伝送し、伝送先でまた元に戻します。

そういう信号処理をアナログで行うと非常に大変なんです。

-

アナログ信号をデジタル信号にする仕組み(非圧縮)

出典:インプレス 標準教科書シリーズ「H.264/AVC教科書」

アナログはデジタルに比べて、より複雑な等化処理、イコライズが必要です。

映像信号というのは、高い周波数から低い周波数までの成分を含む波形で表示されます。伝送距離が長くなると、高い周波数ほど減衰していきます。だからこれ を元の波形に戻さなければなりません。さらに、周波数特性も素直なカーブではなくでこぼこがいっぱいあります。それも平坦に補正しなければなりません。

この2つの処理を行う装置は、一般的にイコライザ(等化器)と呼ばれています。

アクセス回線部分の伝送には多く電話線を使いますが、電話線は途中でタップで分岐されています。なぜ分岐されるかというと、設備的な自由度を増すためです。簡単に言うと、Aさんが電話線を使わない時にはBさんが使えるようにしているんですね。しかしそういうものがあると、広い帯域幅の信号を送ると非常に変な波形になってしまうんです。そういうのを一生懸命イコライザで補正するわけです。

このイコライザのようなアナログ処理技術を画像帯域圧縮のようなものに適用しようとすると、非常に限られたことしかできないし、不安定になります。しかしデジタルならば完璧に元に戻るわけです。コンピュータ処理装置というのは、ムーアの法則でどんどん高 度化するわけですから、より高度な処理ができるようになります。

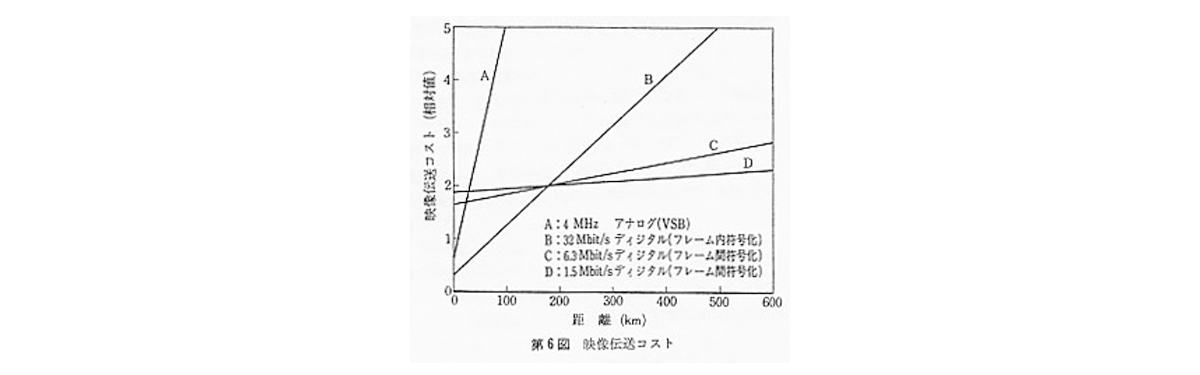

高度な圧縮ができて、ネットワーク・リソースをそれほど使わずにすむということは、経済的にも成り立つということですね。もちろん信号処理そのものは複雑 な処理をするわけですから、それなりのコストがかかります。けれどもLSIにすれば、ネットワークだけでなく、信号元である端末もリーズナブルなコストで実現できるようになりますね。

-

映像伝送コスト

出典:画像電子学会誌 第11巻 第1号

Intel社の創設者の一人であるGordon Moore博士が、1965年に経験則として提唱した「半導体の集積密度は18~24ヶ月で倍増する」という法則。

この法則によれば、半導体の性能は指数関数的に向上していくことになり、今後の半導体の性能向上を予測する際の指標として広く用いられている。

デジタルは「0」と「1」がひっくり返らない範囲であれば、確実に元に戻るわけですから、非常に安定したシステムが実現できますね。

だから運用面でも自由度が増します。メモリを活用すれば、さらに運用が柔軟になります。

たとえばテレビの周波数は、カメラごとに違います。それをどうやって合成するかというと、フレームシンクロライザーというメモリにカメラの速度で書き込ん で、必要なタイミングで読み出しているのです。もしカメラが3つあったとしても、それぞれのカメラのタイミングで書き込んで、共通のタイミングで読み出せ るわけです。

そうすればぴったり同期した映像を作り出すことができるので、そういう面でも自由度が増していきますね。

そのかわり、遅延が生じるということになるんですけどね。

ネットワークバックボーンがデジタルになり、エンドユーザーまでデジタルになった場合、アナログの電話線がなくなるというようなことは起こりうるんでしょうか。

いま、アナログで何かをしようという人はいませんね。

これは余談になりますが、現在東京大学大学院教授の青山氏が60年代後半頃に、電卓でモデムをつくると言っていてびっくりした記憶があります。モデムはDSPという信号処理デバイスでつくっていて、現在はアナログ的な変調はやっていません。それは電卓と同じなんです。

80年代半ばには、画像の符号化でも同じような観点から信号処理が考えられていました。

テレビ会議だけでなく、世の中全体がデジタルに向かっていると思います。

東京大学 大学院情報理工学系研究科 電子情報学専攻 教授

著書に「ディジタル信号処理の基礎(1998)」「シグナルプロセッサ(1990)」「広帯域ISDNとATM技術(1995)」「Super- High-Definition Images(1995)」「光通信工学(1998)」「やさしいATM(1998)」「ブロードバンドがお金を生むしくみ(2001年)」(いずれも共 著または監修)などがある。

ありがとうございました。

次回からは、「標準化について」を数回に分けてお伺いしたいと思います。