11.テレビ会議に関わる人間要因(ヒューマン・ファクタ)【映像と音声の相互関係】

ヒューマン・ファクタの最終回は、映像と音声の相互関係についてお伺いします。主にリップシンクがテーマです。

テレビ会議を行う上で、やはりリップシンクは重要なのでしょうか。

リップシンクは文字通り、音声と映像のズレをどのくらい許容できますかというものです。ディスプレイに映っている人が、話しているように感じられるかという問題ですね。

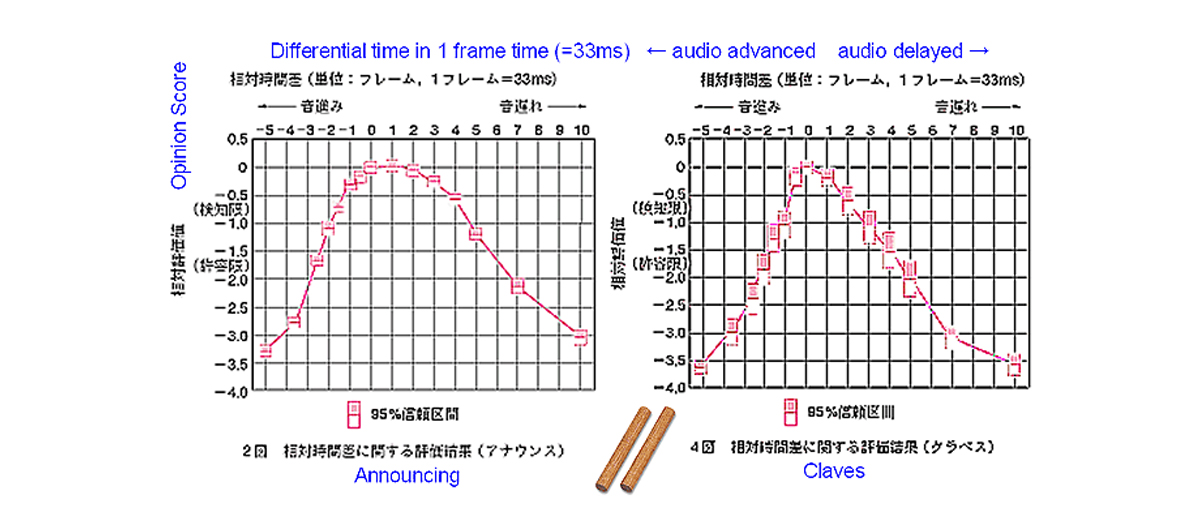

図18はNHKでやった実験で、これに基づいてITU-Rの勧告が出ています。しか

し、内情を聞いていると少し甘めの規格になっているようです。

左側の図は、アナウンスをしている時のものです。横軸の0から左、つまりマイナスの方は音声の方が先に聞こえるケース、プラスの方は音声が後から聞こえるケースです。単位はフレームで、1フレームは33msになります。

平均評点で検知限は-0.5、許容限は-1.5です。アナウンスの場合は、音声の方が速い場合の検知限が50msくらい(約1.5フレーム)、音声が遅れ る場合は130msくらい(約4フレーム)です。音声の方が遅い分には気が付きにくくて、これも視線の不一致の場合(第8回図6参照)と同様に非対称という結果が出ています。

-

図18:映像,音声遅延時間差

[出展] 赤井田卓郎,岡田清孝,黒住幸一,林俊一,深谷崇史:

リップシンク~映像と音声のタイミング~, NHK技研だより, 1997年5月号, 1997

音声が速く聞こえる方の検知限や許容限の範囲が狭いのは、自然界の物理現象に反するからだと思います。花火を思い浮かべる と分かりやすいのですが、花火の光が見えてからしばらくすると音が聞こえますよね。だいたい距離が10メートル離れると、音はここでいう1フレームくらい 遅れることになります。約30msですね。だから10メートル離れている人と話をしている場面は、図18の「-1」にあたります。許容範囲です。

もっとも、物理的に10メートル以上離れてしまうと会話を交わすことはできないので、それ以上離れている人と話をして音声と口の動きが不一致だね、なんていうことはありません。

図18のデータの右側はクラベス(拍子木)を叩くものですが、遅延が1フレームでもあると分かってしまいます。特に叩く前に音が出ると、すぐにおかしいと気づきます。このように物を叩いたときのズレよりも、人が話しているときの方が、ズレに対する許容範囲は広いです。

ところがテレビ会議では、信号処理を行う映像のコーデックなどに注意を払わないと300msくらいす ぐに遅れてしまいます。某メーカーさんのテレビ会議システムを調べたんですが、遅延はだいたい6~8フレームくらいでした。8フレームは240msです。 遅延の減少に努力はしていると思いますが、それでもすぐに遅れてしまうんです。

そのような状況下で音声を放っておくと、リップシンクが取れていないとすぐに分かる状況になるんですね。しかし、映像の遅れがどんどん大きくなるのに音声 をただそれに合わせてしまうと、今度はラウンドトリップの問題が出て会話が成立しにくくなってしまいます。これが現在の大きな問題です。

実は放送の世界でも、これが問題になっています。最近のテレビを見ていると、容易に音声と映像があっ ていないと気がつくはずです。頻繁に起きていますよ。それはなぜかというと、いろんなところにフレームシンクロナイザーやDVE(デジタルビデオエフェク ト)などの映像処理が入るからです。それをきちんと補正しないで出しているケースが多いので、よくズレていますね。

面白い話では、リップシンクを検出する装置を作っているある会社がスタンフォード大学に依頼して、 リップシンクが取れているケースとそうでないケースでは訴える度合いについてどう印象が違うのかを試験したレポートがあります。ニュースや政治家などの演 説、あるいは製品の紹介などが素材なんですが、リップシンクが2.5フレームずれると信頼性に欠けるとか説得力に欠けるなどのネガティブな評価になるそう です。

これはパブリックな資料ではありますが、製品を作っている会社が主張しているものなので、多少その点を加味する必要はあります。しかし、興味深いデータではあります。

リップシンクは古くからありながら、非常に今日的な問題でもあるのです。

引用資料:

Effects of Audio-Video Asynchrony on Viewer's Memory, Evaluation of Content and Detection Ability. (Research report prepared for Pixel Instruments by Byron Reeves and David Voelker.)

(※http://www.lipfix.com/file/doc/stanfordresearch.pdfの9番目の資料)

大久保先生が長年リップシンクの研究に携わっている理由を教えてください。

なぜ私がリップシンクについて研究し、長々と主張しているかというと、テレビ会議を皆さんに使ってもらう中で言われた言葉 の中に「テレビ会議中でもほとんど映像なんか見てないよ。映像なんかいらない。音声だけで十分だよ」というものがあったからです。それじゃあいったい映像 は何のためにあるんですか、ということになりますよね。音声だけで十分じゃないかと。

それは確かにそうなんです。映像がなくても会議はできますが、音声がなければ会議は成り立ちません。しかし、多地点から会議に参加している場合などは、い まある人に話しかけてもいい状況なんだろうかとか、現在の話題に相手が関心を持っていてくれるのかどうかなどを確認するためのツールが映像なわけです。

また、映像なんて見ていないという人でも、ときどきちらりと映像を見て、発言のタイミングを計っているはずです。しかし、それを意識しにくいというのはあると思います。

見ることは動物的なのですが、音声は論理的なものです。音声がなければ文字通り話になりませんが、映像はなくても会話はできます。しかし、より円滑に会話をしようとすると映像が必要です。そこに映像を使う意味があると思います。

電話会議は私もよく参加していますが、確かに発言のタイミングが難しいです。いま発言してもいいの か、話しかけたい相手がそこにちゃんといるのか(離席中とか居眠りしているとか)の判断が、音声だけでディスカッションを行う上で難しい点です。しかし発 言のタイミングが分からないと会議が成り立たないかというと、決してそういうわけではありません。でも音声がなければ成り立たないのです。

そのように、映像と音声ではメディアの性格の違いがあります。

それからもう1つ、実際にディスプレイに映っている人が話しているように聞こえるかどうかもキーだと思います。

極端な例ですが、映像を動画ではなく静止画にしたとします。その途端、音は画面ではなくて、スピーカーから聞こえてくるようになるんです。そこが動画を表 示するキーになっていると思うんですね。ディスプレイに映った人の口から声が出ているように聞こえるかどうかが、雰囲気や臨場感、あるいはリアルさを伝え るんだと思います。リップシンクが取れてないと、それができなくなるのが大きな問題です。

しかし現実は映像の方が遅れすぎて、映像に合わせて音声を遅らせてリップシンクを取ろうとすると、今 度は会話がしにくくなります。だからもうリップシンクを取ろうとしていられないというのが実情なんじゃないでしょうか。リップシンクには目を瞑って、会話 が自然にできるようにすることを選択したのでしょう。

もう1つの問題は、帯域が狭いときには映像のコマ落しをして送っていることです。コマ落しをしている ということは即遅延に繋がるので、それもリップシンクが取れない理由になります。取りたくても取れないんですね。特に64kbpsとか128kbpsにな ると1秒間に10枚も送れませんので、それに合わせてリップシンクを取ろうとすると会話ができなくなります。

ブロードバンドの時代ですが、これからは1枚ずつの映像をよくするというよりも、遅延をなくす方にブロードバンドのリソースを使った方がいいんじゃないかと思います。それが私の主張です。

今後システムの処理が速くなれば、映像の遅延などが解消されますか。それともブロードバンドを利用することの方が圧倒的に効果が高いのでしょうか。

まずは帯域ですね。

1枚の映像を符号化するときの情報量は一定ではなく、複雑な映像の時はたくさんの情報量があって、簡単な映像の時は少ないわけです。限られた帯域幅では、 複雑な映像を1枚送るだけで時間がかかってしまいます。だから複雑な映像がたくさんあるときにはコマ落しをしたり、落とさずちゃんと送ろうとすると時間が かかったりするのです。しかし帯域幅があれば、この点は解消されますね。

1フレームの間に発生した情報量を1フレームの間に送りきれてしまえば、バッファーをして貯えるために遅延が生じるということはなくなります。今後はそういう風に帯域幅を使えるようになるのではないかという期待はしています。

特に最近はアクセシビリティ (情報への近づきやすさ)といいますか、体が自由にならなくなったことに配慮する方向になってきています。身障者に対してだけではなく、健常者であっても 高齢になればたとえば身振り手振りに頼らざるを得なくなるなどそういう考慮です。現在ではこれが、ITUでの一つの流れになっています。しかし耳の聞こえ ない人に手話を使うとなると、コマ落ちした途端に意味が通じなくなってしまうんです。

商品を売る側の立場になると、その場で表示される映像が綺麗な方がいいのかもしれませんが、使う側の立場からはみると、遅延なく届けてくれる方がいいわけです。

映像の綺麗さと使いやすいシステムは必ずしもイコールではないということですね。

帯域幅が限られている場合には、1枚ずつの映像をキレイに出してコマを落とすというのがよく取られるアプローチです。そうするとリップシンクの問題や映像の動きの再現性などが犠牲になります。 ブロードバンドになれば、映像も綺麗でコマ落しもなく、遅延も少ないということも成し得るので、ブロードバンドのリソースはそちらに向けるべきではないか、それがだんだん可能になるんじゃないかという風に感じています。

スピーカーを置く位置はどのようにシステムに影響しますか。

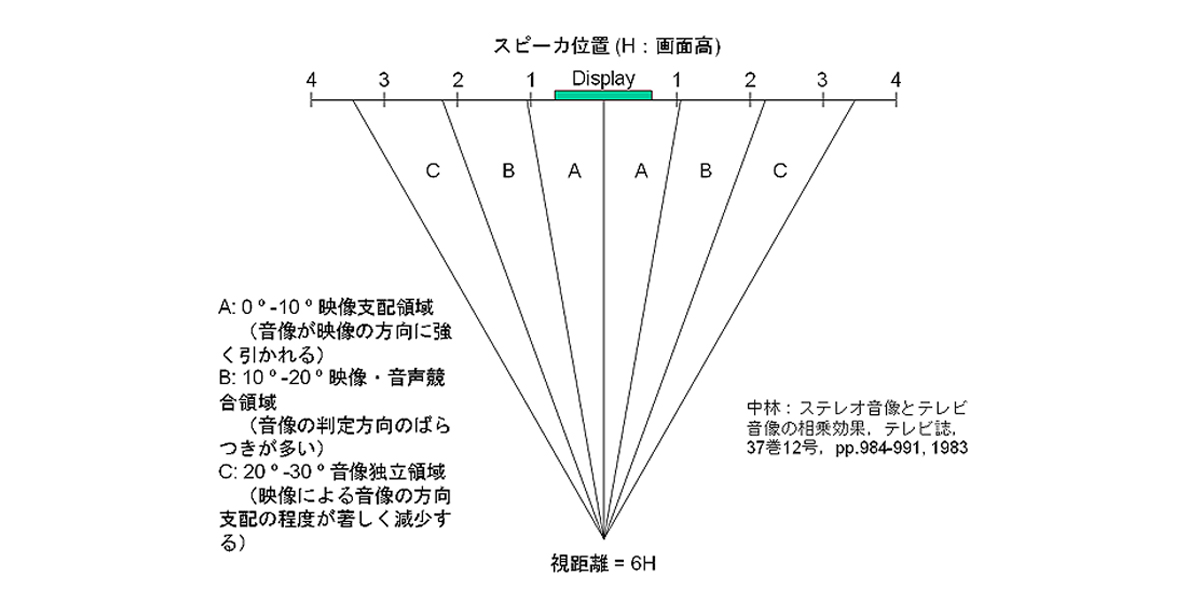

図19は「音像定位に及ぼす映像の影響」が調べられた結果です。物理的にスピーカーをどこにおけば、ディスプレイに映っている人物が話をしているように感じるかという実験です。

-

図19:音像定位に及ぼす映像の影響

Aゾーンは、音が映像の方向に強く引かれる範囲です。スピーカーがこの範囲にあるなら、動画が表示されていればそこから音 声が出ているように聞こえます。これはかなり許容度があって、Bゾーンでも人物の口から聞こえる場合もあるし、スピーカーから聞こえる場合もあります。た だし、Aゾーンであっても静止画になった途端に、スピーカーから音が聞こえるように感じます。

Cゾーンになると、明らかにスピーカーから聞こえてくるようになります。

ここから分かるのは、カメラの時よりも音声の方が自由度が大きいということです。大きなディスプレイの場合、その両端にスピーカーがあると物理的距離はありますが、ちゃんとディスプレイに映った人物から声が聞こえます。

ディスプレイの人の口から声が出ているように感じるかどうかが、テレビ会議システム設計の指標じゃないかと感じています。

ヒューマン・ファクタの目指すところは何でしょうか。

製品を作る人が何を目指しているかによると思いますけれども、突き詰めるとシステムの使いやすさでしょう。 すごく泥臭くいえば、売れるものを作ることを目指しているということなんでしょうね。売れるものというのはユーザーに受け入れられるもので、では受け入れられるものというのは何だろうということから、それをもう少し分解してヒューマン・ファクタという視点でデータを取ったり、結果を反映しているんじゃないかと思います。

※本文中に掲載された図表は、大久保先生の講義資料を元に作成したものです。

ありがとうございました。人間の行動や能力などがシステムに関係するヒューマン・ファクタは、非常に興味深いテーマでした。

次回からは、「テレビ会議の進歩」についてお伺いします。